Si estás aquí, es porque sabes que la inteligencia artificial (IA) está en auge. Es una de las tecnologías más comentadas y con una demanda creciente de profesionales. Pero, ¿por dónde debes empezar? ¡Estamos aquí para ayudarte! Aprender inteligencia artificial desde cero comienza con una sólida base en ciencia de datos.

¿Por qué estudiar Inteligencia Artificial?

Los puestos de trabajo relacionados con la ciencia de datos, como data scientist, data analyst o data engineer, están entre las profesiones más demandadas hoy en día. Las razones para estudiar IA son muchas: variadas salidas laborales, salarios atractivos y la oportunidad de trabajar en tareas que nunca son aburridas. Trabajar en IA significa estar en la vanguardia de la innovación.

¿Qué necesitas estudiar para dedicarte a la Inteligencia Artificial?

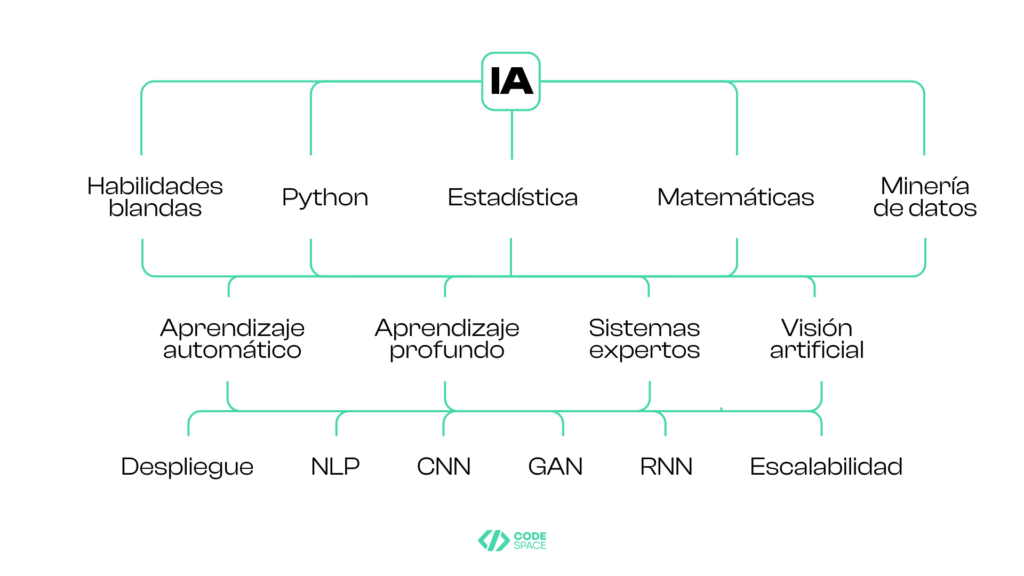

La base para ingresar al campo de la IA es adquirir conocimientos sólidos en ciencia de datos y programación con Python. Pero eso es solo el comienzo. La inteligencia artificial es un área amplia que requiere aprender varias habilidades y técnicas.

Fundamentos de la Ciencia de Datos y programación con Python

Aprender a programar con Python implica familiarizarte con sus funciones, comprensiones y manejo de errores. Necesitarás configurar tu entorno de trabajo con Jupyter Notebooks y Anaconda, y trabajar en entornos virtuales y PIP. Además, Git y GitHub serán tus aliados.

Una vez que domines Python, podrás usarlo para la visualización de datos con librerías como Matplotlib y Seaborn. También te adentrarás en el big data con librerías como Pandas y NumPy. Esto te permitirá:

- Entender el papel del Data Science en la toma de decisiones basada en datos: La ciencia de datos es crucial para convertir datos en información útil. Aprenderás a analizar datos para tomar decisiones informadas y estratégicas en diversas áreas, desde negocios hasta investigación científica.

- Utilizar variables, tipos de datos y operaciones básicas con Python: Familiarizarte con los conceptos básicos de programación en Python, como variables, tipos de datos (enteros, flotantes, cadenas, listas, etc.) y operaciones básicas (suma, resta, concatenación, etc.), es esencial para cualquier proyecto de IA.

- Crear estructuras de control como condicionales y bucles con Python: Las estructuras de control, como los condicionales (if, else, elif) y los bucles (for, while), te permiten controlar el flujo de tu programa y realizar tareas repetitivas de manera eficiente.

- Definir y usar funciones con Python: Las funciones son bloques de código reutilizables que realizan una tarea específica. Aprender a definir y utilizar funciones te ayudará a escribir código más limpio y modular.

- Utilizar NumPy para la manipulación de matrices y operaciones numéricas: NumPy es una librería fundamental para la manipulación de matrices y la realización de operaciones matemáticas complejas. Aprenderás a crear y manipular arrays, realizar operaciones algebraicas y trabajar con funciones matemáticas avanzadas.

- Usar Pandas para manipulación y análisis de datos tabulares: Pandas es una librería poderosa para la manipulación y análisis de datos en formato tabular. Aprenderás a leer y escribir datos, filtrar, agrupar y transformar datos, y realizar análisis exploratorios.

- Entender operaciones comunes como filtrado, agrupación y transformación de datos: Estas operaciones son esenciales para preparar y limpiar datos antes de analizarlos. Aprenderás a filtrar datos según criterios específicos, agrupar datos para resumir información y transformar datos para adecuarlos a tus necesidades.

- Crear gráficos estáticos y dinámicos para explorar y comunicar patrones en los datos con Matplotlib y Seaborn: La visualización de datos es crucial para entender patrones y tendencias. Aprenderás a crear gráficos estáticos y dinámicos que te ayudarán a comunicar tus hallazgos de manera efectiva.

- Personalizar gráficos para mejorar la legibilidad y el impacto visual con Matplotlib y Seaborn: La personalización de gráficos te permitirá mejorar la claridad y el impacto visual de tus visualizaciones, haciendo que tus datos sean más comprensibles y atractivos.

Matemáticas y estadística para Data Science

Las matemáticas son fundamentales para la programación y la IA. Necesitarás conocimientos en álgebra lineal, cálculo, estadísticas y probabilidad para comprender los algoritmos y modelos detrás de la IA.

Estadística descriptiva e inferencial: La estadística descriptiva te permite resumir y describir las características de un conjunto de datos, mientras que la estadística inferencial te ayuda a hacer predicciones y generalizaciones sobre una población a partir de una muestra.

Representación gráfica de distribuciones de datos: Aprenderás a representar gráficamente distribuciones de datos utilizando histogramas, gráficos de caja y bigotes, y otros tipos de visualizaciones que te ayudarán a entender la distribución y variabilidad de tus datos.

Conceptos básicos de probabilidad y teorema de Bayes: La probabilidad es la base de muchos algoritmos de IA. Aprenderás conceptos básicos de probabilidad, eventos y distribuciones de probabilidad, así como la aplicación del teorema de Bayes en la inferencia y toma de decisiones.

Inferencia estadística y pruebas de hipótesis: La inferencia estadística te permite hacer estimaciones sobre una población a partir de una muestra. Aprenderás a construir intervalos de confianza y realizar pruebas de hipótesis para evaluar afirmaciones sobre los datos.

Álgebra lineal para operaciones de datos: El álgebra lineal es fundamental para muchas técnicas de machine learning. Aprenderás a realizar operaciones de transformación y manipulación de datos utilizando matrices y vectores.

Aplicaciones en machine learning como regresión lineal y PCA: La regresión lineal es una técnica básica de machine learning para modelar relaciones entre variables. El análisis de componentes principales (PCA) es una técnica de reducción de dimensionalidad que te ayudará a simplificar tus datos sin perder información importante.

Aprendizaje Automático (Machine Learning)

El aprendizaje automático tiene varios enfoques:

- Aprendizaje supervisado: Modelos entrenados con datos etiquetados. Aprenderás a utilizar algoritmos como la regresión lineal, la regresión logística, los árboles de decisión, las máquinas de vectores de soporte (SVM), los k-vecinos más cercanos (KNN) y las redes neuronales artificiales para predecir resultados basados en datos históricos.

- Aprendizaje no supervisado: Descubrimiento de patrones en datos sin etiquetas. Aprenderás técnicas como el clustering (agrupamiento), la reducción de dimensionalidad y la asociación de reglas para encontrar estructuras ocultas en los datos.

- Aprendizaje semi-supervisado: Combinación de datos etiquetados y no etiquetados. Este enfoque es útil cuando tienes una cantidad limitada de datos etiquetados y quieres aprovechar los datos no etiquetados para mejorar el rendimiento del modelo.

- Aprendizaje por refuerzo: Modelos que aprenden a través de la interacción con un entorno. Aprenderás a entrenar agentes que toman decisiones secuenciales y reciben recompensas o penalizaciones en función de sus acciones, con el objetivo de maximizar la recompensa acumulada.

- Aprendizaje por transferencia: Uso de modelos preentrenados en dominios relacionados. Esta técnica es especialmente útil cuando tienes un conjunto de datos limitado o careces de recursos para entrenar un modelo desde cero.

Aprendizaje Profundo (Deep Learning)

El aprendizaje profundo es una extensión del aprendizaje automático. Comprender las redes neuronales artificiales y arquitecturas como CNNs (Redes Neuronales Convolucionales), GANs (Redes Generativas Adversarias) y RNNs (Redes Neuronales Recurrentes) es esencial.

Estructura y funcionamiento de una neurona artificial: Aprenderás cómo las neuronas artificiales imitan el funcionamiento de las neuronas biológicas y cómo se utilizan para construir redes neuronales.

Composición de capas en una red neuronal: Las redes neuronales están compuestas por capas de neuronas. Por ello, debes aprender a configurar y conectar estas capas para crear modelos de deep learning.

Uso de TensorFlow o PyTorch para definir y entrenar modelos: TensorFlow y PyTorch son dos de las librerías más populares para el desarrollo de modelos de deep learning.

Construcción de redes neuronales y configuración de capas: Aprenderás a construir redes neuronales desde cero, configurando las capas, las funciones de activación y las funciones de pérdida para optimizar el rendimiento del modelo.

Aplicaciones de CNN en Computer Vision y RNN en NLP: Las CNNs son especialmente útiles para tareas de visión por computadora, como la clasificación de imágenes, mientras que las RNNs son ideales para el procesamiento del lenguaje natural y las series temporales.

Procesamiento del Lenguaje Natural y Visión Artificial

El Procesamiento del Lenguaje Natural (NLP, por sus siglas en inglés) y la Visión por Computadora (CV, por sus siglas en inglés) son áreas especializadas dentro de la inteligencia artificial que se centran en cómo las máquinas pueden entender y procesar el lenguaje humano y la información visual, respectivamente.

Procesamiento del Lenguaje Natural (NLP):

El NLP se ocupa de la interacción entre las computadoras y el lenguaje humano. Implica enseñar a las máquinas a interpretar, comprender y generar lenguaje humano de una manera que sea valiosa. Algunas de las aplicaciones más comunes del NLP incluyen:

- Análisis de Sentimientos: Determinar el tono o la emoción detrás de un texto, como opiniones en redes sociales o reseñas de productos.

- Chatbots y Asistentes Virtuales: Crear sistemas que puedan mantener conversaciones con los usuarios, respondiendo preguntas y realizando tareas.

- Traducción Automática: Convertir texto de un idioma a otro de manera automática.

- Reconocimiento de Voz: Convertir el habla en texto, permitiendo la interacción con dispositivos a través de comandos de voz.

- Resumen Automático: Generar resúmenes concisos de documentos largos.

Para trabajar en NLP, es esencial comprender cómo las máquinas procesan el lenguaje humano. Esto incluye el aprendizaje de técnicas como el análisis sintáctico y semántico, el etiquetado de partes del discurso, y el uso de modelos de lenguaje avanzados como BERT y GPT.

Visión por Computadora (CV):

La visión por computadora se centra en cómo las máquinas pueden interpretar y procesar información visual del mundo. Esto incluye imágenes y videos. Algunas de las aplicaciones más comunes de la visión por computadora incluyen:

- Reconocimiento de Imágenes: Identificar y clasificar objetos dentro de una imagen.

- Detección de Objetos: Localizar y etiquetar objetos específicos en una imagen o video.

- Reconocimiento Facial: Identificar y verificar personas a partir de sus características faciales.

- Análisis de Imágenes Médicas: Ayudar en el diagnóstico médico mediante el análisis de radiografías, resonancias magnéticas y otras imágenes médicas.

- Conducción Autónoma: Permitir que los vehículos autónomos comprendan y naveguen por su entorno.

Para trabajar en visión por computadora, es fundamental aprender sobre técnicas de procesamiento de imágenes, como la detección de bordes, la segmentación de imágenes y el uso de redes neuronales convolucionales (CNN) para tareas de clasificación y detección.

Si te ha gustado este artículo, échale un vistazo a nuestro Máster en Data Analytics y Data Science + IA y descubre el contenido que te permitirá dar los primeros pasos en un sector lleno de oportunidades.